Bereit zum Abheben: Wie KI Übersetzungs-Engines beschleunigen wird

Wir verwenden bereits seit einiger Zeit Übersetzungs-Engines, um die bestmögliche Übersetzung für jeden Text zu erreichen. Mit der Einbeziehung der künstlichen Intelligenz (KI) können wir diesen Service jetzt auf die nächste Stufe heben. Generative KI ist zwar nicht ideal für maschinelle Übersetzung, doch mit einer magischen Prise linguistischer Ressourcen können wir Übersetzungen generieren, die den erforderlichen Stil, den Ton, die Terminologie und so ziemlich alles andere berücksichtigen, was für ein bestimmtes Projekt erforderlich ist. Sehen wir uns dies im Folgenden an, mit einem kurzen Überblick über die Entwicklung, einem animierten Film und dem Versprechen besserer Übersetzungen.

Die Geschichte der Übersetzungs-Engines im Überblick

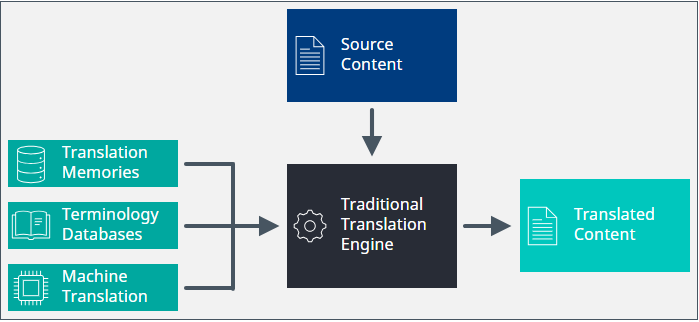

Als unsere neue Cloud-Plattform entwickelt wurde, entschieden wir uns für einen neuen Ansatz für die Anordnung und Nutzung linguistischer Ressourcen. Bis dahin waren alle linguistischen Ressourcen isoliert behandelt worden, und es gab klar getrennte Aufgaben für Translation Memory, Terminologie und maschinelle Übersetzung. Damals haben wir uns zum Ziel gesetzt, diese Ressourcen zusammenzubringen, um einen synergistischen Service zu schaffen, der auf Basis aller verfügbaren Informationen das bestmögliche Match liefern würde. Schluss mit dem Ansatz, zuerst ein Translation Memory anzuwenden, dann den noch nicht übersetzten Text maschinell zu übersetzen und anschließend den Übersetzer:innen beim Bearbeiten des übersetzten Textes die Terminologie zur Verfügung zu stellen. Unsere Vision bestand darin, die Effektivität der Ressourcen zu maximieren, um immer „das bestmögliche Match“ zu schaffen. Dies war die Geburtsstunde der Übersetzungs-Engine.

Einige von Ihnen kennen vielleicht den Aardman-Animationsfilm „Chicken Run – Hennen rennen“. Darin kam eine ziemlich gruselige Maschine vor, die Hühner in Pasteten verwandelte. Wie die Hühner zu Pasteten wurden, wurde nie gezeigt oder im Einzelnen besprochen – es war einfach eine geheimnisvolle und unheimliche Maschine, aber zweifellos ein Triumph der Technik. Mrs. Tweedy fasste die Funktionsweise der Maschine in dem Satz zusammen: „Das Huhn kommt rein, die Pastete kommt raus“. Was hat das mit Übersetzung zu tun, höre ich Sie fragen. Naja, ich fand schon immer, dass eine Übersetzungs-Engine eine ähnlich geheimnisvolle Maschine ist (wenn auch hoffentlich nicht ganz so gruselig oder unheimlich). Statt Hühnern gaben wir Text hinein, statt Pasteten erhielten wir Übersetzungen. „Der Text kommt rein, die Übersetzung kommt raus.“ Sie brauchten nicht zu wissen, wie es funktioniert, konnten aber sicher sein, dass jede nur mögliche Information aus den linguistischen Ressourcen herausgeholt wurde und dass die bestmögliche Übersetzung dabei herauskommen würde. Die Abbildung unten zeigt diesen Ansatz der „geheimnisvollen Kiste“.

Manche der „Tricks“, die wir dabei anwenden, sind genau das, was Sie von einem solchen Ansatz erwarten würden. Sie umfassen einige herkömmliche KI-Technologien, unter anderem:

- Fragmenterkennung

- Fuzzy-Match-Optimierung

- Vorschläge für maschinelle Übersetzung mit der entsprechenden Terminologie

Alles gut und schön, werden Sie denken. Gute Idee. Gut gemacht. Handschlag und Schulterklopfen für alle. Dann kommt 2023 und sagt: „Hey Leute, wisst ihr was? KI ist da!“ Die Vorreiter der KI-Revolution waren die hübschen generativen Chat-Modelle, die wir auffordern können, Gedichte zu verfassen, eine Pressemitteilung zu schreiben oder sich eine einprägsame neue LinkedIn-Überschrift auszudenken. OpenAI schien allen voraus zu sein, aber dann kamen andere dazu. Google, AWS, Meta und andere haben bereits ihre Hüte in den Ring geworfen. Sie können auch darauf wetten, dass noch mehr dazukommen werden, man hört sie schon heranstürmen. KI hat sich also bereits fest etabliert. Was unternehmen wir nun?

Zeit für ein Upgrade

Der Aufstieg der KI gibt uns die Chance, unsere Übersetzungs-Engines hochzustufen und zu optimieren. Bisher hatten wir fast die Grenzen dessen erreicht, was aus den linguistischen Ressourcen herauszuholen war, aber jetzt können wir so viel mehr erreichen. Diese Chatbots verwenden im Prinzip alle die gleiche Technologie. Riesige Mengen linguistischer Daten werden analysiert und verarbeitet, um ein sogenanntes „LLM“ zu schaffen. [Anmerkung für Sprachpedanten: LLM ist kein Akronym, sondern ein Initialwort. Akronyme werden als neues Wort ausgesprochen, wie z. B. NATO, SONAR, LASER und YOLO. Bei Initialwörtern dagegen werden die Buchstaben einzeln gesprochen, wie z. B. bei DNA, OMG, GmbH oder FAQ. MPEG und JPEG sind Ausnahmen von dieser Regel!] Aber zurück zu LLM. Einige von Ihnen fragen vielleicht: „Was ist das?“ Nun, es steht für Large Language Model, und für unsere Branche ist das Wort in der Mitte natürlich ganz besonders interessant. Mit diesen LLMs können unsere Übersetzungs-Engines alle Fesseln abwerfen und leistungsstarke neue Funktionen nutzen, die sich direkt in unsere Übersetzungstechnologien integrieren lassen. Ein LLM kann beispielsweise bei folgenden Dingen helfen:

- Text von einer Sprache in eine andere übersetzen, wenn Kontextinformationen und Richtlinien vorgegeben wurden.

- Übersetzungen, die mit neuronaler maschineller Übersetzung erstellt wurden, per Post-Editing nachbearbeiten.

- Die Qualität übersetzter Texte bewerten und Verbesserungsvorschläge machen.

- Ausgangstext umschreiben, damit er den Unternehmensstil und die richtige Terminologie trifft.

Die Korrektur maschineller oder konventioneller Übersetzungen kommt demnächst dazu, aber im Moment konzentrieren wir uns auf den ersten Punkt in dieser Liste. Wir haben bereits eine OpenAI Translator-App veröffentlicht, die Sie in Trados Studio verwenden können. Diese nutzt ein LLM, um Text in Dokumenten zu transformieren, zu optimieren, zu analysieren und alternative Übersetzungen vorzuschlagen. Sie unterstützt auch Eingabeaufforderungen. Ich will hier nicht zu sehr ins Detail gehen, aber es lohnt sich, einen Blick auf die Wiki-Seite in der RWS Community zu werfen. Dort erfahren, wie Sie die Eingabeaufforderung verwenden können, um den Stil, den Tonfall oder die Länge zu verändern. Was Sie damit nicht erhalten, ist Zugriff auf all die hübschen linguistischen Ressourcen, die wir in einer Translation Engine zusammenfassen. Das ist unser Geheimrezept.

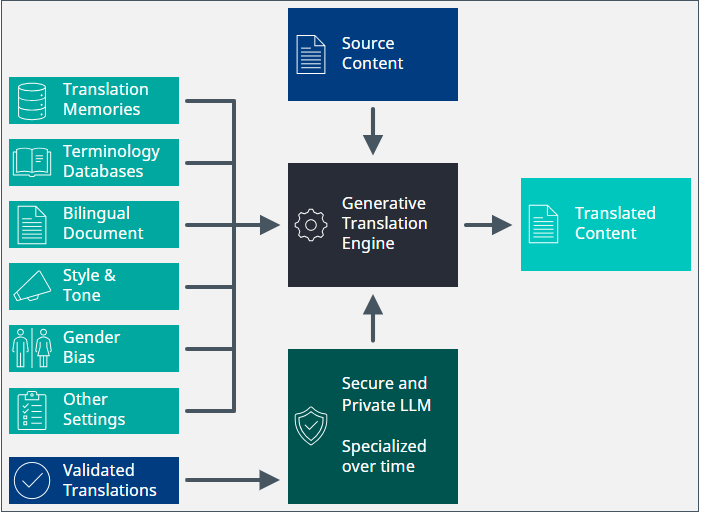

Dank KI können unsere Übersetzungs-Engines jetzt bessere Übersetzungen liefern als je zuvor. Um einen Satz von einer Sprache in eine andere zu übersetzen, können wir folgende Informationen in das LLM einspeisen:

- Wie andere Segmente im selben Dokument übersetzt wurden

- Wie ähnliche Segmente in der Vergangenheit übersetzt wurden (Wiederverwendung der Fuzzy-Match-Technologie)

- Welche Termini im Ausgangstext identifiziert wurden und wie sie übersetzt werden sollen

- Den gewünschten Übersetzungsstil (formell, informell, freundlich, professionell usw.)

- Andere Einstellungen wie maximale Länge oder geschlechtsneutrale Sprache

Mit all diesen Informationen kann uns das LLM genau das gewünschte Ergebnis liefern. Darüber hinaus können wir das LLM anhand des typischen Workflows eines Übersetzungsprojekts „schulen“, um es laufend zu verbessern. Indem wir die endgültigen, überprüften Übersetzungen wieder einspeisen, lernt das Modell daraus und macht im Laufe der Zeit immer bessere Vorschläge. Super. Wir geben Ihre Inhalte an ein öffentlich verfügbares LLM weiter und erhalten hochwertige Übersetzungen zurück. Das muss Sie doch freuen. Nein? Das „öffentlich verfügbar“ macht Ihnen Sorgen? Keine Angst – ich bin sicher, dass die netten Menschen bei einem der oben erwähnten Unternehmen Ihr geistiges Eigentum nicht im gesamten Internet verbreiten. Immer noch nicht überzeugt? Gut, wie wäre es dann, wenn wir all dies in einem sicheren und privat gehosteten LLM anbieten? Auf diese Weise können Sie sicher sein, dass Ihre Daten ganz allein Ihnen gehören. Das folgende Diagramm zeigt unsere neue Übersetzungs-Engine. Es kommen dabei keine Hühner zu Schaden.

Rollout der neuen Funktionen

Unsere erste Implementierung erfolgt in Form einer neuen Aufgabe, die Trados-Kund:innen in einen benutzerdefinierten Workflow aufnehmen können, wenn sie Zugriff auf unseren leistungsstarken Workflow-Editor haben. Dadurch erhalten Benutzer:innen jetzt schon die Chance, die Möglichkeiten unseres neuen Ansatzes zu erleben. Im weiteren Verlauf werden wir das LLM in die Kernfunktionen aufnehmen, damit alle davon profitieren können. Halten Sie also die Augen und Ohren nach weiteren Neuigkeiten offen, die Sie über unsere Community und unsere Social-Media-Kanäle erfahren.